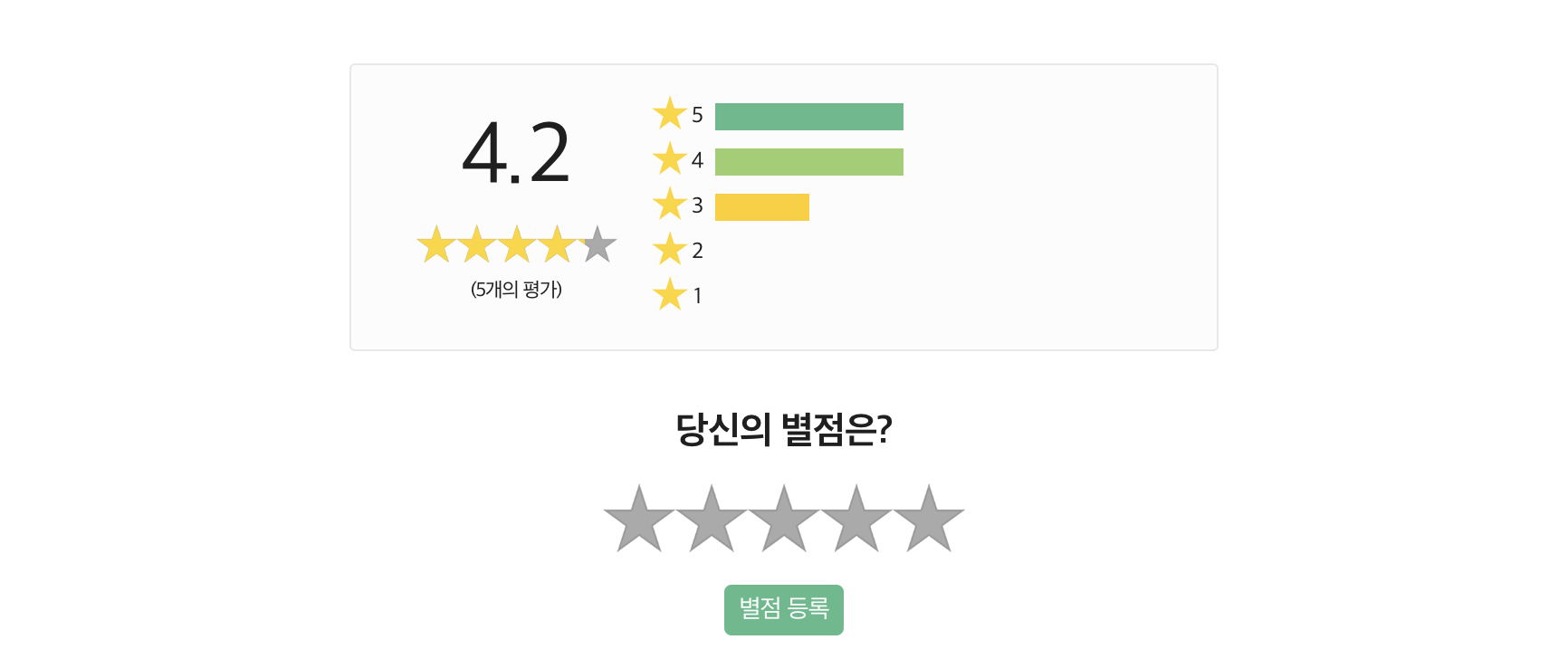

Retrived from https://xetown.com/topics/1105861 배달 음식 가게 리뷰를 보다 보면 별점 5점 평가를 자주 접하곤 한다. 그런데 별점 평가가 평균이 돼 있다. 단지 “만족합니까?” 한 가지 질문을 하고는 무엇에 만족해서 높은 점수는 줬는지는 모를 평가로 다른 사람의 응답을 평균을 계산하는 식이다. 그도 그럴 것이 무엇이 만족스러웠는지도 묻지 않는다.

Retrived from https://ryun1004.tistory.com/680 이러한 방식을 Likert scaling

5점 평가의 정확성?

별점 평가가 정확할까? 아니다. 부정확하다. 5점 평가는 동양에서 부정확하게 동작한다. 그렇다면 7점 평가로 늘리면 더 정확한가? 아니다. 역시 부정확하다. 동양권에서 실험한 바로는 그렇다

그래서 각종 만족도 조사에서 1점부터 5점을 매기라고 하고 있지만, 이상하게도 정확한 측정이 불가능하다. 맥락에 따라 “보통이다” 혹은 “매우 만족”을 선택할 테니까

Retrived from http://www.jeenoo.co.kr/bbs/board.php?bo_table=check1&wr_id=4165&page=&page= 특히 여러 연구에서 보고된 바를 정리한 결과

근본 질문: 근데 별점이 평균 낼 수 있는 거였나?

그런데 근본 질문을 놓치면 안 된다. Likert scaling

그리고 한 가지 더. Likert scaling이런 상황에 빠지면 단순 합산한 평가 점수가 높다 하더라도 이를 믿을 수 없고 실제로는 중간 어딘가 평가를 한 사람의 의견이 더 중요 해진다.

이러느니 차라리 좋아요 버튼이 낫다!

사람은 생각보다 대충 판단하는 존재다

나쁜 평가에 더 귀 기울이는 사회가 되려면 피드백 기술이 필요하다.

좋은 평가에는 상세한 이유가 없으나, 나쁜 평가에는 상세한 이유가 있다. 무엇인가 더 잘 해 낼 수 있을 거 같은데 기대보다 결과가 안 좋은 경우 충분히 그럴 수 있다. 그런데 나쁜 걸 기술 없이 말하면 상대는 듣지 않는다. 나쁜 걸 악평을 쏟아내기 보다는 잘 할 수 있을만한 걸 어떻게 하면 될지 강점을 중심으로 조곤조곤 말해 보는 게 어떨까

평가는 성장과 도약을 위해 존재해야 하지, 누군가를 망하게 해서는 안 된다.

{4226869:DVEMAQHD};{4226869:2ACT5W68},{4226869:R74FRJAA},{4226869:BTXJIUZB};{4226869:R74FRJAA};{4226869:A78BDA6V};{4226869:SYK8Z5IX},{4226869:4RD3BL7N},{4226869:A78BDA6V},{4226869:2ZJNQFYH};{4226869:BTXJIUZB};{4226869:DVEMAQHD};{4226869:H9X8ELVZ};{4226869:DVEMAQHD};{4226869:MIDNHLSF},{4226869:QX6625BY},{4226869:EUYS8MZ2};{4226869:92UQG9MQ};{4226869:R74FRJAA};{4226869:DVEMAQHD};{4226869:E5WPSNIR};{4226869:PTS2HJA5}

apa

author

asc

no

1001

%7B%22status%22%3A%22success%22%2C%22updateneeded%22%3Afalse%2C%22instance%22%3A%22zotpress-16df0248dfe9780ac7a6ef49265049d8%22%2C%22meta%22%3A%7B%22request_last%22%3A0%2C%22request_next%22%3A0%2C%22used_cache%22%3Atrue%7D%2C%22data%22%3A%5B%7B%22key%22%3A%22SYK8Z5IX%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22B%5Cu00f6ckenholt%22%2C%22parsedDate%22%3A%222017%22%2C%22numChildren%22%3A1%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3EB%26%23xF6%3Bckenholt%2C%20U.%20%282017%29.%20Measuring%20response%20styles%20in%20Likert%20items.%20%3Ci%3EPsychological%20Methods%3C%5C%2Fi%3E%2C%20%3Ci%3E22%3C%5C%2Fi%3E%281%29%2C%2069%26%23x2013%3B83.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1037%5C%2Fmet0000106%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1037%5C%2Fmet0000106%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22Measuring%20response%20styles%20in%20Likert%20items.%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Ulf%22%2C%22lastName%22%3A%22B%5Cu00f6ckenholt%22%7D%5D%2C%22abstractNote%22%3A%22The%20recently%20proposed%20class%20of%20item%20response%20tree%20models%20provides%20a%20flexible%20framework%20for%20modeling%20multiple%20response%20processes.%20This%20feature%20is%20particularly%20attractive%20for%20understanding%20how%20response%20styles%20may%20affect%20answers%20to%20attitudinal%20questions.%20Facilitating%20the%20disassociation%20of%20response%20styles%20and%20attitudinal%20traits%2C%20item%20response%20tree%20models%20can%20provide%20powerful%20process%20tests%20of%20how%20different%20response%20formats%20may%20affect%20the%20measurement%20of%20substantive%20traits.%20In%20an%20empirical%20study%2C%203%20response%20formats%20were%20used%20to%20measure%20the%202-dimensional%20Personal%20Need%20for%20Structure%20traits.%20Different%20item%20response%20tree%20models%20are%20proposed%20to%20capture%20the%20response%20styles%20for%20each%20of%20the%20response%20formats.%20These%20models%20show%20that%20the%20response%20formats%20give%20rise%20to%20similar%20trait%20measures%20but%20different%20response-style%20effects.%20%28PsycINFO%20Database%20Record%20%28c%29%202017%20APA%2C%20all%20rights%20reserved%29%22%2C%22date%22%3A%222017%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.1037%5C%2Fmet0000106%22%2C%22ISSN%22%3A%221939-1463%22%2C%22url%22%3A%22http%3A%5C%2F%5C%2Fdoi.apa.org%5C%2Fgetdoi.cfm%3Fdoi%3D10.1037%5C%2Fmet0000106%22%2C%22collections%22%3A%5B%22PYGFZGZT%22%5D%2C%22dateModified%22%3A%222017-10-14T13%3A18%3A58Z%22%7D%7D%2C%7B%22key%22%3A%2292UQG9MQ%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Braga%20et%20al.%22%2C%22parsedDate%22%3A%222015%22%2C%22numChildren%22%3A1%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3EBraga%2C%20J.%20N.%2C%20Ferreira%2C%20M.%20B.%2C%20%26amp%3B%20Sherman%2C%20S.%20J.%20%282015%29.%20The%20effects%20of%20construal%20level%20on%20heuristic%20reasoning%3A%20The%20case%20of%20representativeness%20and%20availability.%20%3Ci%3EDecision%3C%5C%2Fi%3E%2C%20%3Ci%3E2%3C%5C%2Fi%3E%283%29%2C%20216%26%23x2013%3B227.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1037%5C%2Fdec0000021%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1037%5C%2Fdec0000021%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22The%20effects%20of%20construal%20level%20on%20heuristic%20reasoning%3A%20The%20case%20of%20representativeness%20and%20availability.%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Jo%5Cu00e3o%20N%22%2C%22lastName%22%3A%22Braga%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22M%5Cu00e1rio%20B%22%2C%22lastName%22%3A%22Ferreira%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Steven%20J%22%2C%22lastName%22%3A%22Sherman%22%7D%5D%2C%22abstractNote%22%3A%22%22%2C%22date%22%3A%222015%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.1037%5C%2Fdec0000021%22%2C%22ISSN%22%3A%222325-9973%22%2C%22url%22%3A%22http%3A%5C%2F%5C%2Fdoi.apa.org%5C%2Fgetdoi.cfm%3Fdoi%3D10.1037%5C%2Fdec0000021%22%2C%22collections%22%3A%5B%22YQSSPK99%22%2C%22JK9EMN6W%22%5D%2C%22dateModified%22%3A%222016-05-16T21%3A24%3A43Z%22%7D%7D%2C%7B%22key%22%3A%22EUYS8MZ2%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Cao%20et%20al.%22%2C%22parsedDate%22%3A%222015%22%2C%22numChildren%22%3A1%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3ECao%2C%20M.%2C%20Drasgow%2C%20F.%2C%20%26amp%3B%20Cho%2C%20S.%20%282015%29.%20Developing%20Ideal%20Intermediate%20Personality%20Items%20for%20the%20Ideal%20Point%20Model.%20%3Ci%3EOrganizational%20Research%20Methods%3C%5C%2Fi%3E%2C%20%3Ci%3E18%3C%5C%2Fi%3E%282%29%2C%20252%26%23x2013%3B275.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1177%5C%2F1094428114555993%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1177%5C%2F1094428114555993%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22Developing%20Ideal%20Intermediate%20Personality%20Items%20for%20the%20Ideal%20Point%20Model%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22M%22%2C%22lastName%22%3A%22Cao%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22F%22%2C%22lastName%22%3A%22Drasgow%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22S%22%2C%22lastName%22%3A%22Cho%22%7D%5D%2C%22abstractNote%22%3A%22The%20importance%20of%20intermediate%20items%20has%20been%20overlooked%20since%20the%20emergence%20of%20dominance-based%20Likert-type%20scales.%20The%20current%20study%20aims%20to%20advance%20our%20understanding%20of%20the%20psychometric%20properties%20of%20intermediate%20items%20by%20showing%20that%20they%20can%20be%20successfully%20calibrated%20by%20an%20ideal%20point%20model.%20A%20student%20sample%20and%20an%20MTurk%20sample%20were%20selected%20to%20answer%20personality%20scales%20with%20intermediate%20items%20included.%20Results%20showed%20that%20personality%20scales%20with%20intermediate%20items%20demonstrated%20satisfactory%20model%20fits%20to%20the%20ideal%20point%20model%2C%20but%20not%20to%20the%20dominance%20model.%20When%20analyzed%20with%20the%20ideal%20point%20model%2C%20intermediate%20items%20provided%20more%20information%20than%20extreme%20items%20for%20respondents%20with%20high%20latent%20trait%20levels.%20Among%20four%20proposed%20domains%20of%20intermediate%20items%20%28Frequency%2C%20Average%2C%20Condition%2C%20and%20Transition%2C%20%5Cu201cFACT%5Cu201d%29%2C%20the%20Average%20domain%20was%20consistently%20found%20to%20exhibit%20the%20best%20properties.%20The%20proportion%20of%20intermediate%20items%20in%20the%20scale%20also%20affected%20the%20model%20fit%20and%20the%20validity%20of%20the%20scale.%20%5BABSTRACT%20FROM%20AUTHOR%5D%22%2C%22date%22%3A%222015%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.1177%5C%2F1094428114555993%22%2C%22ISSN%22%3A%221094-4281%22%2C%22url%22%3A%22http%3A%5C%2F%5C%2Form.sagepub.com%5C%2Fcgi%5C%2Fdoi%5C%2F10.1177%5C%2F1094428114555993%255Cn10.1177%5C%2F1094428114555993%255Cnhttp%3A%5C%2F%5C%2Fsearch.ebscohost.com%5C%2Flogin.aspx%3Fdirect%3Dtrue%26db%3Dbth%26AN%3D101214898%26site%3Dehost-live%22%2C%22collections%22%3A%5B%22774T3KIG%22%2C%22YQSSPK99%22%2C%2268Q98UFI%22%5D%2C%22dateModified%22%3A%222016-06-29T20%3A41%3A27Z%22%7D%7D%2C%7B%22key%22%3A%22MIDNHLSF%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Carter%20and%20Dalal%22%2C%22parsedDate%22%3A%222010%22%2C%22numChildren%22%3A1%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3ECarter%2C%20N.%20T.%2C%20%26amp%3B%20Dalal%2C%20D.%20K.%20%282010%29.%20An%20ideal%20point%20account%20of%20the%20JDI%20Work%20satisfaction%20scale.%20%3Ci%3EPersonality%20and%20Individual%20Differences%3C%5C%2Fi%3E%2C%20%3Ci%3E49%3C%5C%2Fi%3E%287%29%2C%20743%26%23x2013%3B748.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1016%5C%2Fj.paid.2010.06.019%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1016%5C%2Fj.paid.2010.06.019%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22An%20ideal%20point%20account%20of%20the%20JDI%20Work%20satisfaction%20scale%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Nathan%20T.%22%2C%22lastName%22%3A%22Carter%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Dev%20K.%22%2C%22lastName%22%3A%22Dalal%22%7D%5D%2C%22abstractNote%22%3A%22Applied%20psychologists%20have%20begun%20to%20show%20interest%20in%20an%20ideal%20point%20Item%20Response%20Theory%20%28IRT%29%20model%2C%20the%20Generalized%20Graded%20Unfolding%20Model%20%28GGUM%29.%20As%20opposed%20to%20the%20traditional%20dominance%20models%20based%20on%20the%20Likert%20method%2C%20such%20as%20the%20Graded%20Response%20Model%20%28GRM%29%20and%20the%20Nominal%20Response%20Model%20%28NRM%29%2C%20the%20GGUM%20does%20not%20assume%20that%20responses%20have%20a%20monotonically%20increasing%20relationship%20with%20the%20latent%20attribute.%20Currently%2C%20it%20is%20somewhat%20unclear%20as%20to%20when%20an%20ideal%20point%20process%20should%20be%20assumed.%20Here%2C%20the%20GRM%20and%20the%20NRM%2C%20two%20dominance%20IRT%20models%2C%20are%20evaluated%20against%20the%20GGUM%2C%20an%20ideal%20point%20IRT%20model%2C%20in%20fitting%20scales%20of%20the%20JDI.%20Only%20the%20Work%20scale%20possesses%20a%20large%20number%20of%20items%20that%20unfold.%20Fit%20was%20better%20under%20the%20GGUM%20than%20the%20GRM%20or%20NRM.%20Attribute%20estimates%20for%20the%20dominance%20models%20correlate%20.99%2C%20whereas%20GGUM%20estimates%20correlated%20.85%20with%20GRM%20and%20NRM%20estimates.%20Unfolding%20items%20in%20the%20Work%20scale%20showed%20marked%20differences%20at%20the%20response-option%20level.%20It%20is%20proposed%20that%20ideal%20point%20processes%20may%20better%20theoretically%20and%20empirically%20explain%20appraisals%20of%20Work%20satisfaction.%20%3F%3F%202010%20Elsevier%20Ltd.%22%2C%22date%22%3A%222010%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.1016%5C%2Fj.paid.2010.06.019%22%2C%22ISSN%22%3A%2201918869%22%2C%22url%22%3A%22%22%2C%22collections%22%3A%5B%22774T3KIG%22%2C%22YQSSPK99%22%5D%2C%22dateModified%22%3A%222016-11-01T11%3A47%3A47Z%22%7D%7D%2C%7B%22key%22%3A%22QX6625BY%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Drasgow%20et%20al.%22%2C%22parsedDate%22%3A%222010%22%2C%22numChildren%22%3A1%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3EDrasgow%2C%20F.%2C%20Chernyshenko%2C%20O.%20S.%2C%20%26amp%3B%20Stark%2C%20S.%20%282010%29.%2075%20Years%20After%20Likert%3A%20Thurstone%20Was%20Right%21%20%3Ci%3EIndustrial%20and%20Organizational%20Psychology%3C%5C%2Fi%3E%2C%20%3Ci%3E3%3C%5C%2Fi%3E%2C%20465%26%23x2013%3B476.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1111%5C%2Fj.1754-9434.2010.01273.x%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1111%5C%2Fj.1754-9434.2010.01273.x%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%2275%20Years%20After%20Likert%3A%20Thurstone%20Was%20Right%21%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Fritz%22%2C%22lastName%22%3A%22Drasgow%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Oleksandr%20S.%22%2C%22lastName%22%3A%22Chernyshenko%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Stephen%22%2C%22lastName%22%3A%22Stark%22%7D%5D%2C%22abstractNote%22%3A%22For%20over%20three-quarters%20of%20a%20century%20researchers%20and%20practitioners%20have%20analyzed%20rating%20scale%20data%20using%20methods%20that%20assume%20a%20dominance%20response%20process%20wherein%20an%20individual%20high%20on%20the%20trait%20assessed%20is%20assumed%20to%20answer%20positively%20with%20high%20probability.%20This%20approach%20derives%20from%20Likert%27s%20famous%201932%20approach%20to%20the%20development%20and%20analysis%20of%20rating%20scales.%20In%20this%20paper%2C%20we%20argue%20that%20Likert%20scaling%20and%20related%20methods%20are%20misguided.%20Instead%2C%20we%20propose%20that%20methods%20that%20have%20evolved%20from%20Thurstone%20%281927%2C%201928%2C%201929%29%20scaling%20provide%20a%20better%20representation%20of%20the%20choice%20process%20underlying%20rating%20scale%20judgments.%20These%20methods%20hypothesize%20an%20ideal%20point%20response%20process%20where%20the%20probability%20of%20endorsement%20is%20assumed%20to%20be%20directly%20related%20to%20the%20proximity%20of%20the%20statement%20to%20the%20individual%27s%20standing%20on%20the%20assessed%20trait.%20We%20review%20some%20research%20showing%20the%20superiority%20of%20ideal%20point%20methods%20for%20personality%20assessment%20and%20then%20describe%20several%20settings%20in%20which%20ideal%20point%20methods%20should%20provide%20tangible%20improvements%20over%20traditional%20approaches%20to%20assessment.%22%2C%22date%22%3A%222010%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.1111%5C%2Fj.1754-9434.2010.01273.x%22%2C%22ISSN%22%3A%221754-9426%22%2C%22url%22%3A%22%22%2C%22collections%22%3A%5B%22774T3KIG%22%2C%22YQSSPK99%22%2C%2268Q98UFI%22%5D%2C%22dateModified%22%3A%222017-06-20T08%3A09%3A08Z%22%7D%7D%2C%7B%22key%22%3A%22DVEMAQHD%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Likert%22%2C%22parsedDate%22%3A%221932%22%2C%22numChildren%22%3A2%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3ELikert%2C%20R.%20%281932%29.%20A%20technique%20for%20the%20measurement%20of%20attitudes.%20%3Ci%3EArchives%20of%20Psychology%3C%5C%2Fi%3E%2C%20%3Ci%3E22%3C%5C%2Fi%3E%28140%29%2C%201%26%23x2013%3B55.%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22A%20technique%20for%20the%20measurement%20of%20attitudes%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Rensis%22%2C%22lastName%22%3A%22Likert%22%7D%5D%2C%22abstractNote%22%3A%22The%20project%20conceived%20in%201929%20by%20Gardner%20Murphy%20and%20the%20writer%20aimed%20first%20to%20present%20a%20wide%20array%20of%20problems%20having%20to%20do%20with%20five%20major%20%5C%22attitude%20areas%5C%22%5Cu2014international%20relations%2C%20race%20relations%2C%20economic%20conflict%2C%20political%20conflict%2C%20and%20religion.%20The%20kind%20of%20questionnaire%20material%20falls%20into%20four%20classes%3A%20yes-no%2C%20multiple%20choice%2C%20propositions%20to%20be%20responded%20to%20by%20degrees%20of%20approval%2C%20and%20a%20series%20of%20brief%20newspaper%20narratives%20to%20be%20approved%20or%20disapproved%20in%20various%20degrees.%20The%20monograph%20aims%20to%20describe%20a%20technique%20rather%20than%20to%20give%20results.%20The%20appendix%2C%20covering%20ten%20pages%2C%20shows%20the%20method%20of%20constructing%20an%20attitude%20scale.%20A%20bibliography%20is%20also%20given.%22%2C%22date%22%3A%221932%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%22%22%2C%22ISSN%22%3A%220006-8993%22%2C%22url%22%3A%22%22%2C%22collections%22%3A%5B%5D%2C%22dateModified%22%3A%222016-09-12T09%3A14%3A14Z%22%7D%7D%2C%7B%22key%22%3A%222ZJNQFYH%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Plieninger%20and%20Meiser%22%2C%22parsedDate%22%3A%222014-10-20%22%2C%22numChildren%22%3A1%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3EPlieninger%2C%20H.%2C%20%26amp%3B%20Meiser%2C%20T.%20%282014%29.%20Validity%20of%20Multiprocess%20IRT%20Models%20for%20Separating%20Content%20and%20Response%20Styles.%20%3Ci%3EEducational%20and%20Psychological%20Measurement%3C%5C%2Fi%3E%2C%20%3Ci%3E74%3C%5C%2Fi%3E%285%29%2C%20875%26%23x2013%3B899.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1177%5C%2F0013164413514998%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1177%5C%2F0013164413514998%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22Validity%20of%20Multiprocess%20IRT%20Models%20for%20Separating%20Content%20and%20Response%20Styles%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Hansj%5Cu00f6rg%22%2C%22lastName%22%3A%22Plieninger%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Thorsten%22%2C%22lastName%22%3A%22Meiser%22%7D%5D%2C%22abstractNote%22%3A%22Response%20styles%2C%20the%20tendency%20to%20respond%20to%20Likert-type%20items%20irrespective%20of%20content%2C%20are%20a%20widely%20known%20threat%20to%20the%20reliability%20and%20validity%20of%20self-report%20measures.%20However%2C%20it%20is%20still%20debated%20how%20to%20measure%20and%20control%20for%20response%20styles%20such%20as%20extreme%20responding.%20Recently%2C%20multiprocess%20item%20response%20theory%20models%20have%20been%20proposed%20that%20allow%20for%20separating%20multiple%20response%20processes%20in%20rating%20data.%20The%20rationale%20behind%20these%20models%20is%20to%20define%20process%20variables%20that%20capture%20psychologically%20meaningful%20aspects%20of%20the%20response%20process%20like%2C%20for%20example%2C%20content-%20and%20response%20style-related%20processes.%20The%20aim%20of%20the%20present%20research%20was%20to%20test%20the%20validity%20of%20this%20approach%20using%20two%20large%20data%20sets.%20In%20the%20first%20study%2C%20responses%20to%20a%207-point%20rating%20scale%20were%20disentangled%2C%20and%20it%20was%20shown%20that%20response%20style-related%20and%20content-related%20processes%20were%20selectively%20linked%20to%20extraneous%20criteria%20of%20response%20styles%20and%20content.%20The%20second%20study%2C%20using%20a%204-point%20rating%20scale%2C%20focused%20on%20a%20content-related%20criterion%20and%20revealed%20a%20substantial%20suppression%20effect%20of%20response%20style.%20The%20findings%20have%20implications%20for%20both%20basic%20and%20applied%20fields%2C%20namely%2C%20for%20modeling%20response%20styles%20and%20for%20the%20interpretation%20of%20rating%20data.%22%2C%22date%22%3A%222014-10-20%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.1177%5C%2F0013164413514998%22%2C%22ISSN%22%3A%220013-1644%22%2C%22url%22%3A%22http%3A%5C%2F%5C%2Fjournals.sagepub.com%5C%2Fdoi%5C%2F10.1177%5C%2F0013164413514998%22%2C%22collections%22%3A%5B%22774T3KIG%22%2C%22YQSSPK99%22%2C%2297Q9LGKE%22%5D%2C%22dateModified%22%3A%222017-08-13T08%3A16%3A45Z%22%7D%7D%2C%7B%22key%22%3A%22H9X8ELVZ%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Rhemtulla%20et%20al.%22%2C%22parsedDate%22%3A%222012-09%22%2C%22numChildren%22%3A2%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3ERhemtulla%2C%20M.%2C%20Brosseau-Liard%2C%20P.%20%26%23xC9%3B.%2C%20%26amp%3B%20Savalei%2C%20V.%20%282012%29.%20When%20can%20categorical%20variables%20be%20treated%20as%20continuous%3F%20A%20comparison%20of%20robust%20continuous%20and%20categorical%20SEM%20estimation%20methods%20under%20suboptimal%20conditions.%20%3Ci%3EPsychological%20Methods%3C%5C%2Fi%3E%2C%20%3Ci%3E17%3C%5C%2Fi%3E%283%29%2C%20354%26%23x2013%3B373.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1037%5C%2Fa0029315%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1037%5C%2Fa0029315%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22When%20can%20categorical%20variables%20be%20treated%20as%20continuous%3F%20A%20comparison%20of%20robust%20continuous%20and%20categorical%20SEM%20estimation%20methods%20under%20suboptimal%20conditions.%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Mijke%22%2C%22lastName%22%3A%22Rhemtulla%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Patricia%20%5Cu00c9.%22%2C%22lastName%22%3A%22Brosseau-Liard%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Victoria%22%2C%22lastName%22%3A%22Savalei%22%7D%5D%2C%22abstractNote%22%3A%22A%20simulation%20study%20compared%20the%20performance%20of%20robust%20normal%20theory%20maximum%20likelihood%20%28ML%29%20and%20robust%20categorical%20least%20squares%20%28cat-LS%29%20methodology%20for%20estimating%20confirmatory%20factor%20analysis%20models%20with%20ordinal%20variables.%20Data%20were%20generated%20from%202%20models%20with%202-7%20categories%2C%204%20sample%20sizes%2C%202%20latent%20distributions%2C%20and%205%20patterns%20of%20category%20thresholds.%20Results%20revealed%20that%20factor%20loadings%20and%20robust%20standard%20errors%20were%20generally%20most%20accurately%20estimated%20using%20cat-LS%2C%20especially%20with%20fewer%20than%205%20categories%3B%20however%2C%20factor%20correlations%20and%20model%20fit%20were%20assessed%20equally%20well%20with%20ML.%20Cat-LS%20was%20found%20to%20be%20more%20sensitive%20to%20sample%20size%20and%20to%20violations%20of%20the%20assumption%20of%20normality%20of%20the%20underlying%20continuous%20variables.%20Normal%20theory%20ML%20was%20found%20to%20be%20more%20sensitive%20to%20asymmetric%20category%20thresholds%20and%20was%20especially%20biased%20when%20estimating%20large%20factor%20loadings.%20Accordingly%2C%20we%20recommend%20cat-LS%20for%20data%20sets%20containing%20variables%20with%20fewer%20than%205%20categories%20and%20ML%20when%20there%20are%205%20or%20more%20categories%2C%20sample%20size%20is%20small%2C%20and%20category%20thresholds%20are%20approximately%20symmetric.%20With%206-7%20categories%2C%20results%20were%20similar%20across%20methods%20for%20many%20conditions%3B%20in%20these%20cases%2C%20either%20method%20is%20acceptable.%22%2C%22date%22%3A%222012-09%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.1037%5C%2Fa0029315%22%2C%22ISSN%22%3A%221939-1463%22%2C%22url%22%3A%22http%3A%5C%2F%5C%2Fdx.doi.org%5C%2F10.1037%5C%2Fa0029315.supp%22%2C%22collections%22%3A%5B%22PYGFZGZT%22%2C%22R5LG6EJK%22%2C%22YQSSPK99%22%2C%2268Q98UFI%22%2C%2297Q9LGKE%22%5D%2C%22dateModified%22%3A%222019-06-01T06%3A31%3A32Z%22%7D%7D%2C%7B%22key%22%3A%224RD3BL7N%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Schoonees%20et%20al.%22%2C%22parsedDate%22%3A%222015-12-08%22%2C%22numChildren%22%3A1%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3ESchoonees%2C%20P.%20C.%2C%20van%20de%20Velden%2C%20M.%2C%20%26amp%3B%20Groenen%2C%20P.%20J.%20F.%20%282015%29.%20Constrained%20Dual%20Scaling%20for%20Detecting%20Response%20Styles%20in%20Categorical%20Data.%20%3Ci%3EPsychometrika%3C%5C%2Fi%3E%2C%20%3Ci%3E80%3C%5C%2Fi%3E%284%29%2C%20968%26%23x2013%3B994.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1007%5C%2Fs11336-015-9458-9%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1007%5C%2Fs11336-015-9458-9%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22Constrained%20Dual%20Scaling%20for%20Detecting%20Response%20Styles%20in%20Categorical%20Data%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Pieter%20C.%22%2C%22lastName%22%3A%22Schoonees%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Michel%22%2C%22lastName%22%3A%22van%20de%20Velden%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Patrick%20J.%20F.%22%2C%22lastName%22%3A%22Groenen%22%7D%5D%2C%22abstractNote%22%3A%22Dual%20scaling%20%28DS%29%20is%20a%20multivariate%20exploratory%20method%20equivalent%20to%20correspondence%20analysis%20when%20analysing%20contingency%20tables.%20However%2C%20for%20the%20analysis%20of%20rating%20data%2C%20different%20proposals%20appear%20in%20the%20DS%20and%20correspondence%20analysis%20literature.%20It%20is%20shown%20here%20that%20a%20peculiarity%20of%20the%20DS%20method%20can%20be%20exploited%20to%20detect%20differences%20in%20response%20styles.%20Response%20styles%20occur%20when%20respondents%20use%20rating%20scales%20differently%20for%20reasons%20not%20related%20to%20the%20questions%2C%20often%20biasing%20results.%20A%20spline-based%20constrained%20version%20of%20DS%20is%20devised%20which%20can%20detect%20the%20presence%20of%20four%20prominent%20types%20of%20response%20styles%2C%20and%20is%20extended%20to%20allow%20for%20multiple%20response%20styles.%20An%20alternating%20nonnegative%20least%20squares%20algorithm%20is%20devised%20for%20estimating%20the%20parameters.%20The%20new%20method%20is%20appraised%20both%20by%20simulation%20studies%20and%20an%20empirical%20application.%22%2C%22date%22%3A%222015-12-08%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.1007%5C%2Fs11336-015-9458-9%22%2C%22ISSN%22%3A%220033-3123%22%2C%22url%22%3A%22http%3A%5C%2F%5C%2Flink.springer.com%5C%2F10.1007%5C%2Fs11336-015-9458-9%22%2C%22collections%22%3A%5B%22R5LG6EJK%22%2C%22774T3KIG%22%2C%2297Q9LGKE%22%2C%22YULGN4C5%22%5D%2C%22dateModified%22%3A%222017-08-24T18%3A50%3A30Z%22%7D%7D%2C%7B%22key%22%3A%22E5WPSNIR%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Tay%20et%20al.%22%2C%22parsedDate%22%3A%222011-06-01%22%2C%22numChildren%22%3A4%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3ETay%2C%20L.%2C%20Ali%2C%20U.%20S.%2C%20Drasgow%2C%20F.%2C%20%26amp%3B%20Williams%2C%20B.%20%282011%29.%20Fitting%20IRT%20Models%20to%20Dichotomous%20and%20Polytomous%20Data%3A%20Assessing%20the%20Relative%20Model%26%23x2013%3BData%20Fit%20of%20Ideal%20Point%20and%20Dominance%20Models.%20%3Ci%3EApplied%20Psychological%20Measurement%3C%5C%2Fi%3E%2C%20%3Ci%3E35%3C%5C%2Fi%3E%284%29%2C%20280%26%23x2013%3B295.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1177%5C%2F0146621610390674%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1177%5C%2F0146621610390674%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22Fitting%20IRT%20Models%20to%20Dichotomous%20and%20Polytomous%20Data%3A%20Assessing%20the%20Relative%20Model%5Cu2013Data%20Fit%20of%20Ideal%20Point%20and%20Dominance%20Models%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Louis%22%2C%22lastName%22%3A%22Tay%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Usama%20S.%22%2C%22lastName%22%3A%22Ali%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Fritz%22%2C%22lastName%22%3A%22Drasgow%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Bruce%22%2C%22lastName%22%3A%22Williams%22%7D%5D%2C%22abstractNote%22%3A%22This%20study%20investigated%20the%20relative%20model%5Cu2014data%20fit%20of%20an%20ideal%20point%20item%20response%20theory%20%28IRT%29%20model%20%28the%20generalized%20graded%20unfolding%20model%20%5BGGUM%5D%29%20and%20dominance%20IRT%20models%20%28e.g.%2C%20the%20two-parameter%20logistic%20model%20%5B2PLM%5D%20and%20Samejima%5Cu2019s%20graded%20response%20model%20%5BGRM%5D%29%20to%20simulated%20dichotomous%20and%20polytomous%20data%20generated%20from%20each%20of%20these%20models.%20The%20relative%20magnitudes%20of%20the%20adjusted%20%5Cu03c72%5C%2Fdf%20ratios%20for%20item%20pairs%20and%20item%20triples%20at%20the%20test%20level%20were%20used%20to%20evaluate%20fit.%20Two%20simulation%20studies%20were%20conducted%2C%20one%20for%20dichotomous%20data%20and%20the%20other%20for%20polytomous%20data.%20Relative%20fit%20of%20the%20ideal%20point%20and%20dominance%20models%20were%20compared%20with%20respect%20to%20different%20conditions%3A%20test%20length%2C%20sample%20size%2C%20and%20sample%20type.%20In%20many%20simulated%20conditions%2C%20it%20was%20found%20that%20comparing%20relative%20fits%20%28using%20test-level%20doubles%20and%20triples%20adjusted%20%5Cu03c72%5C%2Fdf%20ratios%29%20almost%20always%20consistently%20pointed%20to%20the%20correct%20IRT%20model.%20However%2C%20GGUM%20could%20fit%20dichotomous%20two-parameter%20logistic%20%282PL%29%20data%20well%20when%20the%20scale%20length%20was%20short%20%28i.e.%2C%2015%20items%29%3B%20nevertheless%2C%20an%20examination%20of%20estimated%20GGUM%20item%20parameters%20clearly%20shows%20dominance%20item%20characteristics.%20Results%20of%20the%20simulation%20studies%20and%20implications%20are%20discussed.%22%2C%22date%22%3A%222011-06-01%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.1177%5C%2F0146621610390674%22%2C%22ISSN%22%3A%220146-6216%2C%201552-3497%22%2C%22url%22%3A%22%22%2C%22collections%22%3A%5B%222934SYNF%22%2C%22YQSSPK99%22%5D%2C%22dateModified%22%3A%222017-08-22T12%3A03%3A57Z%22%7D%7D%2C%7B%22key%22%3A%22A78BDA6V%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Tutz%20and%20Berger%22%2C%22parsedDate%22%3A%222016%22%2C%22numChildren%22%3A1%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3ETutz%2C%20G.%2C%20%26amp%3B%20Berger%2C%20M.%20%282016%29.%20Response%20Styles%20in%20Rating%20Scales%3A%20Simultaneous%20Modeling%20of%20Content-Related%20Effects%20and%20the%20Tendency%20to%20Middle%20or%20Extreme%20Categories.%20%3Ci%3EJournal%20of%20Educational%20and%20Behavioral%20Statistics%3C%5C%2Fi%3E%2C%20%3Ci%3E41%3C%5C%2Fi%3E%283%29%2C%20239%26%23x2013%3B268.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.3102%5C%2F1076998616636850%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.3102%5C%2F1076998616636850%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22Response%20Styles%20in%20Rating%20Scales%3A%20Simultaneous%20Modeling%20of%20Content-Related%20Effects%20and%20the%20Tendency%20to%20Middle%20or%20Extreme%20Categories%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Gerhard%22%2C%22lastName%22%3A%22Tutz%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Moritz%22%2C%22lastName%22%3A%22Berger%22%7D%5D%2C%22abstractNote%22%3A%22Heterogeneity%20in%20response%20styles%20can%20affect%20the%20conclusions%20drawn%20from%20rating%20scale%20data.%20In%20particular%2C%20biased%20estimates%20can%20be%20expected%20if%20one%20ignores%20a%20tendency%20to%20middle%20categories%20or%20to%20extreme%20categories.%20An%20adjacent%20cate-gories%20model%20is%20proposed%20that%20simultaneously%20models%20the%20content-related%20effects%20and%20the%20heterogeneity%20in%20response%20styles.%20By%20accounting%20for%20response%20styles%2C%20it%20provides%20a%20simple%20remedy%20for%20the%20bias%20that%20occurs%20if%20the%20response%20style%20is%20ignored.%20The%20model%20allows%20to%20include%20explanatory%20variables%20that%20have%20a%20content-related%20effect%20as%20well%20as%20an%20effect%20on%20the%20response%20style.%20A%20visualization%20tool%20is%20developed%20that%20makes%20the%20interpretation%20of%20effects%20easily%20accessible.%20The%20proposed%20model%20is%20embedded%20into%20the%20framework%20of%20multivariate%20generalized%20linear%20model%2C%20which%20entails%20that%20common%20estimation%20and%20inference%20tools%20can%20be%20used.%20Existing%20software%20can%20be%20used%20to%20fit%20the%20model%2C%20which%20makes%20it%20easy%20to%20apply.%22%2C%22date%22%3A%222016%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.3102%5C%2F1076998616636850%22%2C%22ISSN%22%3A%221076-9986%22%2C%22url%22%3A%22http%3A%5C%2F%5C%2Fjeb.sagepub.com%5C%2Fcgi%5C%2Fdoi%5C%2F10.3102%5C%2F1076998616636850%22%2C%22collections%22%3A%5B%22774T3KIG%22%2C%22YQSSPK99%22%5D%2C%22dateModified%22%3A%222017-08-14T04%3A43%3A03Z%22%7D%7D%2C%7B%22key%22%3A%22PTS2HJA5%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Voerman%20et%20al.%22%2C%22parsedDate%22%3A%222014%22%2C%22numChildren%22%3A0%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3EVoerman%2C%20L.%2C%20Korthagen%2C%20F.%20A.%20J.%2C%20Meijer%2C%20P.%20C.%2C%20%26amp%3B%20Simons%2C%20R.%20J.%20%282014%29.%20Feedback%20revisited%3A%20Adding%20perspectives%20based%20on%20positive%20psychology.%20Implications%20for%20theory%20and%20classroom%20practice.%20%3Ci%3ETeaching%20and%20Teacher%20Education%3C%5C%2Fi%3E.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1016%5C%2Fj.tate.2014.06.005%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1016%5C%2Fj.tate.2014.06.005%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22Feedback%20revisited%3A%20Adding%20perspectives%20based%20on%20positive%20psychology.%20Implications%20for%20theory%20and%20classroom%20practice%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Lia%22%2C%22lastName%22%3A%22Voerman%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Fred%20A.J.%22%2C%22lastName%22%3A%22Korthagen%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Paulien%20C.%22%2C%22lastName%22%3A%22Meijer%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Robert%20Jan%22%2C%22lastName%22%3A%22Simons%22%7D%5D%2C%22abstractNote%22%3A%22Teacher%20feedback%20has%20mainly%20been%20described%20from%20the%20point%20of%20view%20of%20cognitive%20psychology.%20We%20aim%20to%20add%20to%20the%20body%20of%20knowledge%20on%20teacher%20feedback%20by%20considering%20the%20perspective%20of%20positive%20psychology.%20We%20describe%20possible%20consequences%20of%20two%20concerns%20of%20positive%20psychology%3A%20%281%29%20the%20importance%20of%20%28positive%29%20emotions%20and%20%282%29%20character%20strengths.%20We%20argue%20that%20emotions%20are%20an%20important%20issue%20in%20the%20discussion%20about%20feedback%20and%20challenge%20the%20over-simplification%20of%20feedback%20about%20the%20self.%20As%20a%20way%20of%20stimulating%20positive%20emotions%20and%20character%20strengths%2C%20we%20propose%20to%20focus%20on%20progress%20feedback%20as%20a%20complement%20to%20gap%20feedback.%20%5Cu00a9%202014%20Elsevier%20Ltd.%22%2C%22date%22%3A%222014%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.1016%5C%2Fj.tate.2014.06.005%22%2C%22ISSN%22%3A%220742051X%22%2C%22url%22%3A%22%22%2C%22collections%22%3A%5B%5D%2C%22dateModified%22%3A%222017-09-10T09%3A02%3A27Z%22%7D%7D%2C%7B%22key%22%3A%222ACT5W68%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Wakita%22%2C%22parsedDate%22%3A%222004%22%2C%22numChildren%22%3A1%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3EWakita%2C%20T.%20%282004%29.%20Assessment%20of%20the%20distance%20between%20categories%20in%20rating%20scales%20by%20using%20item%20response%20model.%20%3Ci%3EThe%20Japanese%20Journal%20of%20Psychology%3C%5C%2Fi%3E%2C%20%3Ci%3E75%3C%5C%2Fi%3E%284%29%2C%20331%26%23x2013%3B338.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.4992%5C%2Fjjpsy.75.331%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.4992%5C%2Fjjpsy.75.331%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22Assessment%20of%20the%20distance%20between%20categories%20in%20rating%20scales%20by%20using%20item%20response%20model%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Takafumi%22%2C%22lastName%22%3A%22Wakita%22%7D%5D%2C%22abstractNote%22%3A%22This%20study%20aimed%20to%20assess%20the%20distance%20between%20adjacent%20categories%20of%20rating%20scales.%20It%20is%20common%20practice%20to%20treat%20ordinal%20variables%20as%20interval-scaled%20variables%20in%20the%20analysis%20of%20rating%20scales.%20Strictly%20speaking%2C%20however%2C%20ordinal%20scale%20data%20should%20be%20treated%20as%20such%2C%20since%20there%20is%20little%20reason%20and%20assurance%20that%20they%20are%20equivalent%20to%20interval%20variables.%20In%20view%20of%20this%20practice%2C%20this%20study%20proposes%20a%20method%20to%20assess%20the%20interval%20of%20rating%20scales%2C%20and%20analyzes%20empirical%20data%20in%20order%20to%20examine%20the%20results%20obtained%20by%20the%20method.%20This%20method%20is%20based%20upon%20the%20generalized%20partial%20credit%20model%20which%20is%20one%20of%20item%20response%20theory%20%28IRT%29%20models.%20The%20experiment%20was%20carried%20out%20on%20two%20data%20sets%20that%20differed%20only%20on%20the%20verbal%20phrasing%20of%20the%20rating.%20Main%20results%20of%20the%20study%20were%3A%201%29%20the%20difference%20in%20item%20content%20%28positive%20or%20negative%29%20affects%20the%20width%20of%20a%20neutral%20category%3B%20and%202%29%20the%20distance%20between%20categories%20differs%20significantly%20reflecting%20the%20difference%20in%20verbal%20phrasing.%22%2C%22date%22%3A%222004%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.4992%5C%2Fjjpsy.75.331%22%2C%22ISSN%22%3A%221884-1082%22%2C%22url%22%3A%22http%3A%5C%2F%5C%2Fjoi.jlc.jst.go.jp%5C%2FJST.Journalarchive%5C%2Fjjpsy1926%5C%2F75.331%3Ffrom%3DCrossRef%22%2C%22collections%22%3A%5B%5D%2C%22dateModified%22%3A%222017-02-25T00%3A50%3A52Z%22%7D%7D%2C%7B%22key%22%3A%22R74FRJAA%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Wakita%20et%20al.%22%2C%22parsedDate%22%3A%222012%22%2C%22numChildren%22%3A1%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3EWakita%2C%20T.%2C%20Ueshima%2C%20N.%2C%20%26amp%3B%20Noguchi%2C%20H.%20%282012%29.%20Psychological%20Distance%20Between%20Categories%20in%20the%20Likert%20Scale%3A%20Comparing%20Different%20Numbers%20of%20Options.%20%3Ci%3EEducational%20and%20Psychological%20Measurement%3C%5C%2Fi%3E%2C%20%3Ci%3E72%3C%5C%2Fi%3E%284%29%2C%20533%26%23x2013%3B546.%20%3Ca%20href%3D%27https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1177%5C%2F0013164411431162%27%3Ehttps%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1177%5C%2F0013164411431162%3C%5C%2Fa%3E%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22journalArticle%22%2C%22title%22%3A%22Psychological%20Distance%20Between%20Categories%20in%20the%20Likert%20Scale%3A%20Comparing%20Different%20Numbers%20of%20Options%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Takafumi%22%2C%22lastName%22%3A%22Wakita%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Natsumi%22%2C%22lastName%22%3A%22Ueshima%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Hiroyuki%22%2C%22lastName%22%3A%22Noguchi%22%7D%5D%2C%22abstractNote%22%3A%22This%20study%20examined%20whether%20the%20number%20of%20options%20in%20the%20Likert%20scale%20influences%20the%20psychological%20distance%20between%20categories.%20The%20most%20important%20assumption%20when%20using%20the%20Likert%20scale%20is%20that%20the%20psychological%20distance%20between%20options%20is%20equal.%20The%20authors%20proposed%20a%20new%20algorithm%20for%20calculating%20the%20scale%20values%20of%20options%20by%20apply-%20ing%20item%20response%20theory%20and%20the%20ideas%20ofWakita%20to%20reveal%20the%20influence%20of%20the%20num-%20ber%20of%20categories.%20Three%20types%20of%20questionnaires%20that%20were%20composed%20of%20the%20same%20items%2C%20but%20used%20different%20numbers%20of%20options%20to%20assess%20these%20items%20%28specifically%2C%204-%2C%205-%2C%20and%207-point%20scales%29%2C%20were%20completed%20by%20722%20undergraduate%20students.%20The%20results%20indi-%20cated%20that%20the%20number%20of%20options%20influenced%20the%20psychological%20distance%20between%20options%2C%20particularly%20for%20the%207-point%20scale.%20This%20influence%20was%20revealed%20only%20by%20the%20authors%5Cu2019%20algorithm%3B%20descriptive%20statistics%20and%20coefficients%20of%20reliability%20did%20not%20show%20that%20the%20number%20of%20options%20had%20a%20prominent%20influence.%20The%20importance%20of%20the%20num-%20ber%20of%20options%20and%20the%20new%20algorithm%20are%20discussed.%22%2C%22date%22%3A%222012%22%2C%22language%22%3A%22%22%2C%22DOI%22%3A%2210.1177%5C%2F0013164411431162%22%2C%22ISSN%22%3A%220013-1644%22%2C%22url%22%3A%22http%3A%5C%2F%5C%2Fepm.sagepub.com%22%2C%22collections%22%3A%5B%22R5LG6EJK%22%2C%22YQSSPK99%22%5D%2C%22dateModified%22%3A%222017-02-24T17%3A56%3A08Z%22%7D%7D%2C%7B%22key%22%3A%22BTXJIUZB%22%2C%22library%22%3A%7B%22id%22%3A4226869%7D%2C%22meta%22%3A%7B%22creatorSummary%22%3A%22Yang%20et%20al.%22%2C%22parsedDate%22%3A%222010-05-05%22%2C%22numChildren%22%3A1%7D%2C%22bib%22%3A%22%3Cdiv%20class%3D%5C%22csl-bib-body%5C%22%20style%3D%5C%22line-height%3A%202%3B%20padding-left%3A%201em%3B%20text-indent%3A-1em%3B%5C%22%3E%5Cn%20%20%3Cdiv%20class%3D%5C%22csl-entry%5C%22%3EYang%2C%20Y.%2C%20Harkness%2C%20J.%20A.%2C%20Chin%2C%20T.%2C%20%26amp%3B%20Villar%2C%20A.%20%282010%29.%20Response%20Styles%20and%20Culture.%20In%20J.%20A.%20Harkness%2C%20M.%20Braun%2C%20B.%20Edwards%2C%20T.%20P.%20Johnson%2C%20L.%20E.%20Lyberg%2C%20P.%20Ph.%20Mohler%2C%20B.-E.%20Pennell%2C%20%26amp%3B%20T.%20W.%20Smith%20%28Eds.%29%2C%20%3Ci%3ESurvey%20Methods%20in%20Multinational%2C%20Multiregional%2C%20and%20Multicultural%20Contexts%3C%5C%2Fi%3E%20%28pp.%20203%26%23x2013%3B223%29.%20John%20Wiley%20%26amp%3B%20Sons%2C%20Inc.%20https%3A%5C%2F%5C%2Fdoi.org%5C%2F10.1002%5C%2F9780470609927.ch12%3C%5C%2Fdiv%3E%5Cn%3C%5C%2Fdiv%3E%22%2C%22data%22%3A%7B%22itemType%22%3A%22bookSection%22%2C%22title%22%3A%22Response%20Styles%20and%20Culture%22%2C%22creators%22%3A%5B%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Yongwei%22%2C%22lastName%22%3A%22Yang%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Janet%20A.%22%2C%22lastName%22%3A%22Harkness%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Tzu-yun%22%2C%22lastName%22%3A%22Chin%22%7D%2C%7B%22creatorType%22%3A%22author%22%2C%22firstName%22%3A%22Ana%22%2C%22lastName%22%3A%22Villar%22%7D%2C%7B%22creatorType%22%3A%22editor%22%2C%22firstName%22%3A%22Janet%20A.%22%2C%22lastName%22%3A%22Harkness%22%7D%2C%7B%22creatorType%22%3A%22editor%22%2C%22firstName%22%3A%22Michael%22%2C%22lastName%22%3A%22Braun%22%7D%2C%7B%22creatorType%22%3A%22editor%22%2C%22firstName%22%3A%22Brad%22%2C%22lastName%22%3A%22Edwards%22%7D%2C%7B%22creatorType%22%3A%22editor%22%2C%22firstName%22%3A%22Timothy%20P.%22%2C%22lastName%22%3A%22Johnson%22%7D%2C%7B%22creatorType%22%3A%22editor%22%2C%22firstName%22%3A%22Lars%20E.%22%2C%22lastName%22%3A%22Lyberg%22%7D%2C%7B%22creatorType%22%3A%22editor%22%2C%22firstName%22%3A%22Peter%20Ph.%22%2C%22lastName%22%3A%22Mohler%22%7D%2C%7B%22creatorType%22%3A%22editor%22%2C%22firstName%22%3A%22Beth-Ellen%22%2C%22lastName%22%3A%22Pennell%22%7D%2C%7B%22creatorType%22%3A%22editor%22%2C%22firstName%22%3A%22Tom%20W.%22%2C%22lastName%22%3A%22Smith%22%7D%5D%2C%22abstractNote%22%3A%22%22%2C%22bookTitle%22%3A%22Survey%20Methods%20in%20Multinational%2C%20Multiregional%2C%20and%20Multicultural%20Contexts%22%2C%22date%22%3A%222010-05-05%22%2C%22language%22%3A%22%22%2C%22ISBN%22%3A%22%22%2C%22url%22%3A%22http%3A%5C%2F%5C%2Fdoi.wiley.com%5C%2F10.1002%5C%2F9780470609927.ch12%22%2C%22collections%22%3A%5B%22774T3KIG%22%2C%22JK9EMN6W%22%5D%2C%22dateModified%22%3A%222019-06-26T11%3A48%3A53Z%22%7D%7D%5D%7D

Böckenholt, U. (2017). Measuring response styles in Likert items.

Psychological Methods ,

22 (1), 69–83.

https://doi.org/10.1037/met0000106

Braga, J. N., Ferreira, M. B., & Sherman, S. J. (2015). The effects of construal level on heuristic reasoning: The case of representativeness and availability.

Decision ,

2 (3), 216–227.

https://doi.org/10.1037/dec0000021

Cao, M., Drasgow, F., & Cho, S. (2015). Developing Ideal Intermediate Personality Items for the Ideal Point Model.

Organizational Research Methods ,

18 (2), 252–275.

https://doi.org/10.1177/1094428114555993

Carter, N. T., & Dalal, D. K. (2010). An ideal point account of the JDI Work satisfaction scale.

Personality and Individual Differences ,

49 (7), 743–748.

https://doi.org/10.1016/j.paid.2010.06.019

Drasgow, F., Chernyshenko, O. S., & Stark, S. (2010). 75 Years After Likert: Thurstone Was Right!

Industrial and Organizational Psychology ,

3 , 465–476.

https://doi.org/10.1111/j.1754-9434.2010.01273.x

Likert, R. (1932). A technique for the measurement of attitudes. Archives of Psychology , 22 (140), 1–55.

Plieninger, H., & Meiser, T. (2014). Validity of Multiprocess IRT Models for Separating Content and Response Styles.

Educational and Psychological Measurement ,

74 (5), 875–899.

https://doi.org/10.1177/0013164413514998

Rhemtulla, M., Brosseau-Liard, P. É., & Savalei, V. (2012). When can categorical variables be treated as continuous? A comparison of robust continuous and categorical SEM estimation methods under suboptimal conditions.

Psychological Methods ,

17 (3), 354–373.

https://doi.org/10.1037/a0029315

Schoonees, P. C., van de Velden, M., & Groenen, P. J. F. (2015). Constrained Dual Scaling for Detecting Response Styles in Categorical Data.

Psychometrika ,

80 (4), 968–994.

https://doi.org/10.1007/s11336-015-9458-9

Tay, L., Ali, U. S., Drasgow, F., & Williams, B. (2011). Fitting IRT Models to Dichotomous and Polytomous Data: Assessing the Relative Model–Data Fit of Ideal Point and Dominance Models.

Applied Psychological Measurement ,

35 (4), 280–295.

https://doi.org/10.1177/0146621610390674

Tutz, G., & Berger, M. (2016). Response Styles in Rating Scales: Simultaneous Modeling of Content-Related Effects and the Tendency to Middle or Extreme Categories.

Journal of Educational and Behavioral Statistics ,

41 (3), 239–268.

https://doi.org/10.3102/1076998616636850

Voerman, L., Korthagen, F. A. J., Meijer, P. C., & Simons, R. J. (2014). Feedback revisited: Adding perspectives based on positive psychology. Implications for theory and classroom practice.

Teaching and Teacher Education .

https://doi.org/10.1016/j.tate.2014.06.005

Wakita, T. (2004). Assessment of the distance between categories in rating scales by using item response model.

The Japanese Journal of Psychology ,

75 (4), 331–338.

https://doi.org/10.4992/jjpsy.75.331

Wakita, T., Ueshima, N., & Noguchi, H. (2012). Psychological Distance Between Categories in the Likert Scale: Comparing Different Numbers of Options.

Educational and Psychological Measurement ,

72 (4), 533–546.

https://doi.org/10.1177/0013164411431162

Yang, Y., Harkness, J. A., Chin, T., & Villar, A. (2010). Response Styles and Culture. In J. A. Harkness, M. Braun, B. Edwards, T. P. Johnson, L. E. Lyberg, P. Ph. Mohler, B.-E. Pennell, & T. W. Smith (Eds.), Survey Methods in Multinational, Multiregional, and Multicultural Contexts (pp. 203–223). John Wiley & Sons, Inc. https://doi.org/10.1002/9780470609927.ch12